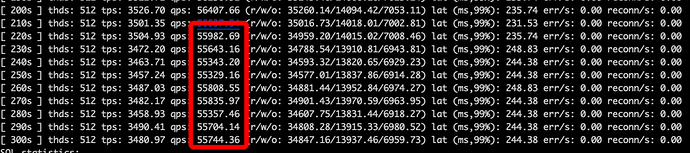

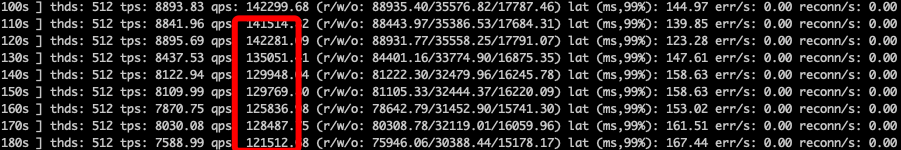

跑sysbench的机器 40c 256G内存

proxy机器 18c 180G内存 两台

mysql机器 18c 180G内存 ssd

my.cnf配置

[mysqld]

##### server #####

basedir = /usr

datadir = /home/mysql/data

tmpdir = /home/mysql/tmp

socket = /var/run/mysqld/mysqld.sock

server_id = 3223269

bind_address = 0.0.0.0

report_host = x.x.x.x

report_port = 3306

myisam_recover_options = BACKUP,FORCE

secure_file_priv = /home/mysql/tmp

default_password_lifetime = 0

character_set_client_handshake = FALSE

character_set_server = utf8mb4

character_set_filesystem = utf8mb4

##### basic #####

skip_name_resolve = ON

transaction_isolation = READ-COMMITTED

read_only = OFF

innodb_flush_log_at_trx_commit = 1

sync_binlog = 1

log_timestamps = system

query_cache_size = 0

host_cache_size = 0

explicit_defaults_for_timestamp = ON

local_infile = OFF

event_scheduler = OFF

gtid_mode = ON

table_open_cache = 20480

thread_cache_size = 5120

performance-schema-instrument = stage/innodb/alter%=ON

performance-schema-instrument = wait/lock/metadata/sql/mdl=ON

performance-schema-consumer-events-stages-current = ON

performance-schema-consumer-events-stages-history = ON

performance-schema-consumer-events-stages-history-long = ON

##### per_thread_buffers #####

max_connections = 30000

max_user_connections = 29950

max_allowed_packet = 67108864

slave_pending_jobs_size_max = 134217728

max_connect_errors = 1000

sort_buffer_size = 2097152

binlog_cache_size = 2097152

##### log #####

log_error = /home/mysql/log/error.log

slow_query_log_file = /home/mysql/log/slowlog/slow.log

long_query_time = 0.1

min_examined_row_limit = 100

slow_query_log = ON

log_queries_not_using_indexes = OFF

log_slow_admin_statements = ON

log_slow_slave_statements = ON

log_throttle_queries_not_using_indexes = 10

log_bin = /home/mysql/log/binlog/binlog

binlog_format = row

expire_logs_days = 3

binlog_rows_query_log_events = ON

binlog_gtid_simple_recovery = ON

relay_log = /home/mysql/log/relaylog/relaylog

general_log = OFF

general_log_file = /home/mysql/log/general.log

##### innodb #####

innodb_page_size = 16384

innodb_buffer_pool_size = 125627793408

innodb_io_capacity = 4000

innodb_io_capacity_max = 16000

innodb_log_file_size = 2147483648

innodb_log_files_in_group = 4

innodb_data_file_path = ibdata1:512M:autoextend

innodb_temp_data_file_path = ibtmp1:12M:autoextend:max:10G

innodb_flush_method = O_DIRECT

innodb_log_buffer_size = 16777216

innodb_lock_wait_timeout = 5

innodb_print_all_deadlocks = ON

innodb_thread_concurrency = 108

innodb_max_undo_log_size = 2147483648

innodb_buffer_pool_dump_pct = 40

innodb_undo_log_truncate = ON

innodb_undo_directory = /home/mysql/data

innodb_undo_tablespaces = 3

innodb_sort_buffer_size = 67108864

innodb_doublewrite = OFF

innodb_numa_interleave = ON

innodb_flush_neighbors = 0

##### replication #####

relay_log_recovery = ON

log_slave_updates = ON

slave_preserve_commit_order = ON

slave_parallel_type = LOGICAL_CLOCK

slave_parallel_workers = 4

master_info_repository = TABLE

relay_log_info_repository = TABLE

enforce_gtid_consistency = ON

skip_slave_start = FALSE

##### semi_sync #####

plugin_load = "rpl_semi_sync_master=semisync_master.so;rpl_semi_sync_slave=semisync_slave.so"

rpl_semi_sync_master_enabled = OFF

rpl_semi_sync_master_wait_no_slave = 1

rpl_semi_sync_master_timeout = 1000

rpl_semi_sync_slave_enabled = OFF

##### other #####

ssl = 0

lock_wait_timeout = 50

disabled_storage_engines = MyISAM,MRG_MYISAM,MEMORY,BLACKHOLE,CSV,ARCHIVE,FEDERATED

innodb_adaptive_hash_index = OFF

tmp_table_size = 83886080

max_heap_table_size = 83886080